Definire epocale la ristrutturazione dell’apparato produttivo mondiale è appropriato di fronte all’estensione, alla rapidità e alla portata delle trasformazioni in atto.

Non è un dibattito futuribile tra accademici o centri studi, è già in atto una lotta a livello globale tra gruppi economici combattuta a colpi di miliardi di dollari di investimenti.

Inedite sono la trasformazione e l’interconnessione dei più svariati settori, che ora si evolvono intrecciandosi gli uni con gli altri: auto, energia, telecomunicazione, mass-media, chimica, meccanica, internet, automazione, ecc. Riassumiamo per sommi capi alcuni di questi aspetti, su cui torneremo.

SOMMARIO

| Titolo | pag. |

| La nuova frontiera quantistica dell’informatica | 1 |

| Il settore IT in Italia | 2-3 |

| L’ingegnere nella storia (parte VII) | 4-5 |

| Energia: le prospettive secondo un manager | 6-7 |

| L’aumento mondiale della scolarizzazione degli occupati | 7-8 |

INVESTIMENTI MILIARDARI PER CAVALCARE LE TRASFORMAZIONI TECNOLOGICHE

Secondo il “Global automotive Outlook del 2018”, realizzato da AlixPartners, nei prossimi otto anni i gruppi auto investiranno 255 MLD$. Significa circa dieci volte di più di quanto fatto nei precedenti otto anni. È lo sviluppo previsto dell’auto elettrica a definire il nuovo paradigma: si ipotizza che il parco di auto elettriche passerà dai 3.1 milioni attuali a 220 milioni nel 2030.

Nel 2017 la Cina si conferma primo mercato con quasi 29 milioni di immatricolazioni sulle oltre 73 milioni avvenute nel mondo. È evidente che se la Cina si converte all’elettrico, gli altri produttori devono adeguarsi: il dragone si sta sostituendo a Washington come paese che impone il modello da seguire. Inoltre con la fuga dal diesel i BIG ridisegnano il mondo dell’auto.

Fiat Chrysler Automotive annuncia il lancio della 500 elettrica per il 2020 dopo un 2019 di chiusura degli stabilimenti di Mirafiori con conseguente cassa integrazione. L’arresto di Carlos Ghosn in Giappone segnala probabilmente la fine o comunque una modifica profonda nell’alleanza Nissan Renault Mitsubishi. La General Motors dà avvio ad un piano di 14.000 licenziamenti (12% dei dipendenti del gruppo), in modo da poter “liberare” 5 miliardi di dollari e gettarli sull’elettrico. Volkswagen e Ford si alleano, il vantaggio competitivo di VW si chiama MQB (Modular Querbaukasten): è una piattaforma che permette di creare auto diverse per stile, brand, tipologia di motorizzazione. Contemporaneamente VW annuncia un piano di 7.000 posti di lavoro in meno per la conversione all’elettrico. È un aspetto che coinvolge tutti i produttori: il motore dell’auto elettrica ha meno componenti, quindi si stima un 15-20% in meno di addetti necessari.

I gruppi del settore si stanno muovendo in una situazione più che mai fluida. Vecchie alleanze vengono meno e se ne stanno delineando di inedite. Inoltre nuovi attori si sostituiscono a quelli tradizionali, in una dinamica che vale per tutti i settori. La battaglia dell’auto, oramai tra tutti i continenti, si intreccia con la battaglia delle telecomunicazioni e quella elettrica.

Nelle telecomunicazioni è conclamata la sfida per la supremazia mondiale. Gli Stati Uniti provano a contrastare il piano MADE IN CINA 2025, hanno messo nel mirino alcuni grandi gruppi cinesi: prima ZTE, ora Huawei.

Il passaggio da 4G a 5G (big data, trasmissione più veloce, IoT, auto connessa, smart city, ecc) sarà uno snodo chiave per definire i rapporti di forza dei prossimi anni. (A pag. 2 del bollettino vedi anche “La nuova frontiera dell’informatica”).

Sul fronte elettrico, le infrastrutture (colonnine di ricarica, smaltimento celle) non sono pienamente al passo con il crescente numero di auto vendute. Si stanno attrezzando. ENEL con stazioni di ricarica in 3 paesi: 28 mila in Italia (ora sono 2750), 8500 in Spagna, 2500 in Romania. Investimenti anche in America Latina e Russia.

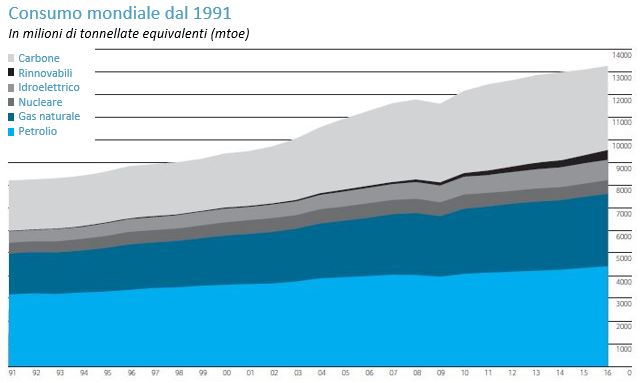

Con la mobilità elettrica, è probabile che si riduca la dipendenza dal petrolio del Medio Oriente, ma si creeranno nuove dipendenze per la carenza delle materie prime oggi fondamentali per le batterie. Il Cobalto ha visto i prezzi balzare del +178% tra il 2016 e il 2017 e la domanda di Litio potrebbe raddoppiare nel 2025. La conversione all’elettrico coinvolge anche la produzione di energia per la ricarica delle batterie, con nuove proporzioni tra le fonti tradizionali e quelle rinnovabili (vedi articolo a pag. 6).

Continua ad aumentare il consumo di carbone per la generazione di energia. I consumi mondiali erano 1.400 mln di tonnellate nel 1965 ora sono più che raddoppiati a 3.760 milioni. Parigi annuncia la riduzione nella produzione del nucleare. Il Giappone dopo lo stop nuke, progetta 30 centrali a carbone sul suo territorio, ma anche in Vietnam e Indonesia. La Cina rappresenta tre quarti delle centrali a carbone nel mondo in costruzione o in fase di progettazione e già oggi consuma metà del carbone mondiale.

Il mondo della energia è scosso dalla fracking revolution, che ha portato gli Stati Uniti a diventare il primo paese produttore di petrolio al mondo; per reazione è nata OPEC PLUS l’alleanza dei paesi OPEC (con a capo Arabia Saudita) e NON OPEC (guidati dalla Russia). Il Qatar in contrasto con i sauditi annuncia di lasciare l’OPEC anche per investire sul Gas Naturale Liquefatto di cui è primo produttore mondiale. Il GNL ha un mercato in forte crescita, triplicato dal 2000, rappresenta nel 2017 un terzo degli scambi totali di gas. L’IEA prevede che la percentuale degli scambi totali del GNL passeranno dal 40% nel 2023 al 53% nel 2040.

Nei trasporti nuove frontiere si stanno sperimentando, due esempi:

Il porto di Amburgo, primo test europeo, ha prenotato i treni Hyperloop (treni a lievitazione magnetica in tubi sottovuoto che viaggiano ad oltre 1000 km/h). Per il trasporto merci si prevede l’avvio tra 5 anni mentre per i passeggeri tra 20.

ALSTOM si metterà a commercializzare treni a idrogeno per il trasporto regionale al posto dei convogli diesel.

Cosa aspettarsi? Le transizioni in atto nei vari settori non saranno un processo indolore. La scienza, la tecnologia e la loro industrializzazione hanno ripercussioni in tutti gli aspetti economici, sociali e politici. Nella società attuale è impossibile una pianificazione “ordinata” (vedi anche a pag. 4, il tentativo fallito negli anni Trenta del secolo scorso). Il modo di produzione capitalistico procede inevitabilmente per sviluppi e crisi. Quella in corso è una partita nuova e come in tutte le partite l’esito è imprevedibile. Di certo aumenterà la componente più scolarizzata degli occupati (vedi articolo a pag. 7), quindi più tecnici e ingegneri che, se coalizzati, possono definire una linea di azione comune.

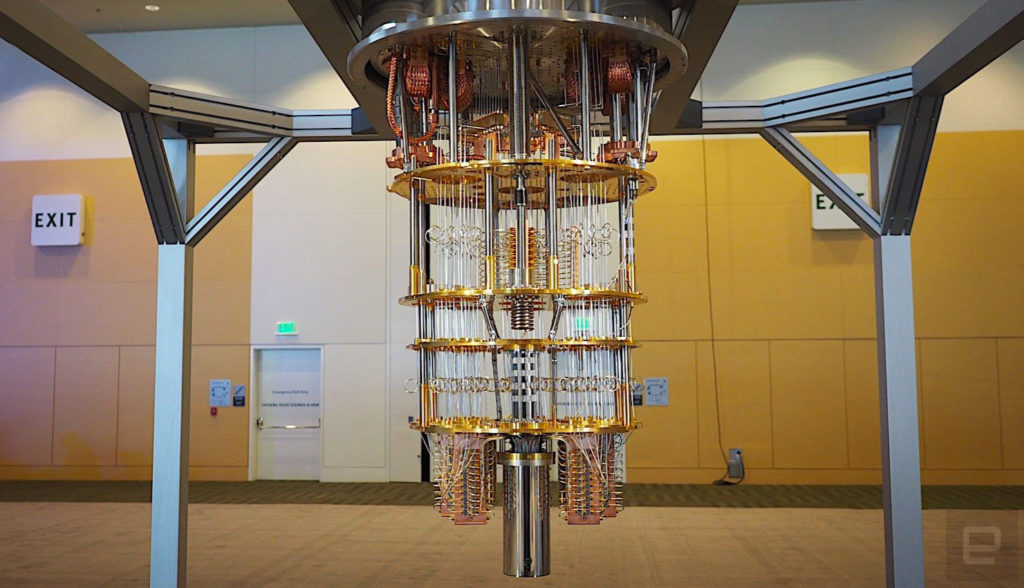

LA NUOVA FRONTIERA QUANTISTICA DELL’INFORMATICA

L’esplorazione del mondo subatomico porta all’inizio del XX secolo alla nascita della meccanica quantistica. Una teoria che il mondo scientifico accettò a fatica in quanto mise in discussione non solo la meccanica classica, ma addirittura le categorie razionali stesse con cui il pensiero scientifico moderno aveva analizzato il mondo fisico fino ad allora.

Il comportamento delle particelle a livello subatomico risulta completamente controintuitivo tanto da far affermare a Richard Feynman (famoso divulgatore e Premio Nobel per la fisica): “Credo di poter dire con sicurezza che nessuno… comprende la meccanica quantistica”. Ma fu proprio lo stesso Feynman, insieme a David Deutsh, che negli anni ‘80 iniziò a teorizzare l’utilizzo dei fenomeni quantistici per costruire computer innovativi. Dagli inizi degli anni ‘90 in poi si è passati dalla teoria alla pratica fino a costruire a cavallo del 2000 i primi elementari computer quantistici. Negli ultimi anni tutti i colossi della tecnologia si sono avventurati in questa sfida e il mondo accademico nel solo 2015 ha prodotto più di 3000 articoli che menzionano l’argomento.

Cosa si intende per quantum computing

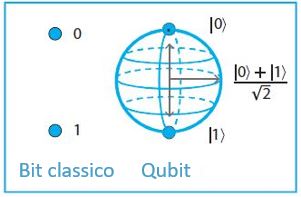

La computazione classica è basata sul bit, unità fondamentale di informazione che può assumere due stati: zero oppure uno. L’unità fondamentale del computer quantistico è il quantum bit (in breve qubit) e sfrutta il fenomeno quantistico della sovrapposizione che permette ad una particella di trovarsi contemporaneamente in due luoghi o in due stati fisici, poiché nella fisica quantistica le particelle sono interpretate come onde di probabilità. Il qubit può assumere, oltre che lo stato uno o zero, una qualsiasi combinazione lineare di questi due stati. Un computer tradizionale può operare con un solo stato alla volta, la sovrapposizione permette invece al computer quantistico di esaminare contemporaneamente tutte le possibili soluzioni di un problema, dotandolo di una potenza di calcolo parallelo superiore a quella di qualsiasi computer classico.

Sfide per l’ingegnerizzazione

Gli sforzi per l’implementazione di un quantum computer si sono concentrati principalmente su due strategie differenti per ottenere i qubit [1]. La prima soluzione consiste nello sfruttare singoli atomi utilizzando i loro livelli energetici elettronici o nucleari (lo spin) per immagazzinare l’informazione quantistica. Nello specifico si utilizzano ioni di itterbio (elemento delle terre rare) intrappolati, tenuti in posizione da raggi laser per poter essere poi manipolati da altri laser. Questo metodo è intrinsecamente scalabile in quanto diversi atomi dello stesso tipo sono praticamente identici; inoltre gli atomi di itterbio mantengono il loro stato quantistico per parecchi minuti. Il problema risiede però nel tenerli sotto controllo e creare sistemi più complessi aumentandone il numero.

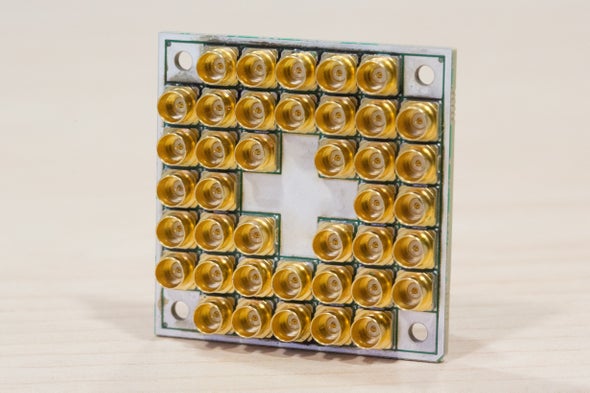

Il secondo approccio crea “atomi artificiali” utilizzando circuiti raffreddati ad una temperatura vicina allo zero assoluto per renderli superconduttori. Nonostante siano composti da molti atomi, i circuiti in questo stato si comportano come singoli qubit controllabili. Ad esempio si può produrre uno stato di sovrapposizione in cui un singolo fotone con frequenza nelle microonde, che attraversa il circuito superconduttore senza alcuna resistenza, può “esserci” o “non esserci” allo stesso tempo. Il notevole vantaggio dei processori che utilizzano questa soluzione è che possono essere prodotti in serie con le stesse tecnologie utilizzate per i circuiti integrati tradizionali.

Quantum Supremacy

IBM è stata la prima ad aprire la strada nel 2016 con un processore quantistico a 5-bit. Nel 2017 ha proposto una nuova soluzione a 20 qubit ma altri si sono aggiunti alla gara: Intel nel gennaio 2018 ha presentato la sua soluzione a 49 qubit superata da Google in marzo con un processore a 72 qubit. Da quest’anno anche la cinese Alibaba si è unita alla competizione con il suo processore da 11 qubit.

La capacità dei qubit di occupare stati multipli in una sola volta fa in modo che la potenza di calcolo aumenti esponenzialmente con il numero di qubit. Processori con un numero di qubit anche limitati come quelli già creati potrebbe teoricamente superare in potenza qualsiasi processore tradizionale. Il problema è mantenere basso il livello di errori: sia che si usi la strategia a ioni, che quella dei circuiti superconduttori, aumentare il numero di qubit rende difficile collegarli e manipolarli conservando i loro stati quantistici. Uno dei maggiori problemi che comporta la creazione di un computer quantistico con un numero consistente di qubit è mantenere schermato il sistema dalle interferenze. La sovrapposizione di una particella viene mantenuta fin tanto che il sistema è isolato: qualsiasi tentativo di osservarlo o misurarlo direttamente costringe la particella a collassare in un singolo stato. A questo punto il qubit “sceglie” uno dei due stati diventando un bit classico.

Si è aperta la gara per la quantum supremacy, cioè arrivare ad un computer quantistico in grado di fare calcoli irrealizzabili per un computer normale.

Gli investimenti dei big

Nel 2017 sono stati investiti 250 milioni di dollari in ricerca nel campo. Tutte le grandi compagnie mondiali stanno guardando alle potenzialità del computer quantistico per superare i limiti del computer tradizionale nel risolvere problemi di Machine Learning, AI e analisi dei big data [2].

Si ritiene che difficilmente saranno prodotti e distribuiti processori quantistici “general purpose”, piuttosto i grandi big dell’information technology metteranno a disposizione la potenza dei loro processori quantistici fornendo servizi specifici in cloud (QCaas Quantum computing as a service) [3].

Tutte le compagnie stanno spendendo molto soprattutto per attrarre a sé programmatori. IBM per prima ha messo a disposizione una piattaforma cloud con una potenza di calcolo del suo primo processore a 5qubit. La piattaforma ha ora 90.000 mila utenti che hanno già lanciato 5 milioni di esperimenti e pubblicato 110 papers [2]. Assieme al lancio del suo processore quantistico, anche Alibaba ha annunciato la creazione di una piattaforma per il quantum computing non ancora aperta al pubblico.

Investimenti dei governi

Oltre alle grandi aziende anche i governi nazionali sono interessati alle potenzialità promesse dai computer quantistici. Le applicazioni militari delle tecnologie che sfruttano i comportamenti delle particelle subatomiche sono molteplici. Prima fra tutte la possibilità di poter decifrare in tempi molto brevi qualsiasi comunicazione fatta con gli algoritmi utilizzati più comunemente, possibilità preclusa a qualsiasi computer tradizionale.

A dimostrazione dell’interesse delle maggiori potenze mondiali per questa tecnologia, basta elencare gli investimenti fatti dai governi nel campo.

A giugno il congresso americano ha approvato all’unanimità il National Quantum Initiative Act con cui creare un fondo di circa 1,3 miliardi di dollari per supportare i progetti di computazione quantistica tra il 2019 e 2023 [4].

L’Unione Europea ha lanciato in ottobre la Quantum Flagship un iniziativa da 1 miliardo di euro in 10 anni per finanziare oltre 5000 ricercatori europei impegnati in ricerche d’avanguardia nel mondo quantistico.

Entrambe le decisioni sembrano essere prese per tenere il passo con la Cina, che quest’anno durante l’ottava conferenza internazionale sulla crittografia quantistica, ha annunciato il suo “multi-location quantum information lab” [4].

Il progetto, che ha ricevuto 10 miliardi dollari dal governo cinese, prevede di integrare ed ampliare diversi laboratori presenti in differenti regioni cinesi tra cui Hefei nella provincia di Anhui, Shanghai, e Beijing. Già nel settembre 2017 era stata inaugurata una linea di comunicazione quantistica (quantum fiber link) che collega queste tre località.

Conclusione

Gli esperti si dividono sulle previsioni riguardo alle prospettive future della computazione quantistica. Probabilmente è impossibile stabilire quale sarà l’impatto dei computer quantistici sulla società, come sostiene il fisico John Preskill: “Sappiamo dalla storia che non abbiamo fantasia sufficiente per prevedere cosa ci possano portare le nuove tecnologie”. Visto il livello degli investimenti, sembrerebbe che i governi e i grandi gruppi dell’IT siano i primi ad aver imparato dalla storia e non vogliano rischiare di avere meno fantasia dei loro concorrenti nel trarre profitto da queste nuove tecnologie.

[1] La corsa alla supremazia dei computer quantistici, Le Scienze, luglio 2017

[2] The race is on to dominate quantum computing, The Economist, agosto 2018

[3] The CIO’s Guide to Quantum Computing, Gartner

[4] China is building a massive multi-location national-level quantum laboratory, Technode, settembre 2018

QED – La strana teoria della luce e della materia, Richard Phillips Feynman, Adelphi, 2010

L’INGEGNERE NELLA STORIA

Parte VII: I Pianificatori

Proseguiamo con gli articoli a carattere storico. L’intento, come abbiamo già esplicitato, è quello di fornire spunti di riflessione a proposito della “figura” e della collocazione sociale degli ingegneri nel corso dei secoli. Tappe utili anche per meglio comprendere la situazione attuale.

La convinzione che l’efficienza e la razionalità del “privato” siano inarrivabili per il “pubblico” ha la forza del luogo comune. Essa riflette, in parte, il contrasto tra «l’organizzazione della produzione» nella singola impresa e l’anarchia che la società riverbera, poco o tanto, su tutto ciò che le attiene. Ha questa radice materiale, ad esempio, l’idea secondo cui la tara che affligge la politica è l’incompetenza: se solo i politici lasciassero fare a “chi sa come si fa”, molti dei problemi sarebbero risolti.

Il congresso di Amsterdam

Spesso è avvenuto che qualche imprenditore di successo, in Italia ma anche altrove, ha costruito un lato della sua immagine, e delle sue fortune politiche, contrapponendo all’inconcludente “teatrino” della vita pubblica romana le proprie competenze private nell’economia reale. In un periodo in cui il marketing elettorale fa i conti, in tutta Europa, con i contraccolpi sociali dell’irruzione asiatica e dei fenomeni migratori, una dose di distinzione dalla “politica” è entrata in quasi tutti i mix pubblicitari in vista del test delle urne. Oggi si tratta di ammansire elettori riottosi, più intimoriti da un futuro improvvisamente e inaspettatamente incerto che non davvero colpiti nei loro, di regola elevati, standard di vita. È utile, a nostro avviso, ricordare un precedente riferito al dibattito innescato dopo la grande depressione degli anni Venti del Novecento.

Di fronte alla catastrofica crisi del 1929, l’idea di gestire il mondo intero con metodi manageriali assunse veste teorica e, per un breve periodo, fu al centro dell’attenzione.

Nell’agosto del 1931, convocati dall’International Industrial Relations Institute (IRI), esponenti americani dello scientific management, dirigenti del socialismo e del sindacalismo europei e una rappresentanza ufficiale del Gosplan russo si riunirono ad Amsterdam per discutere, come recitano gli atti del congresso, di «World Social Economic Planning».

Per l’IRI, un piccolo istituto con sedi a New York e all’Aja, l’incontro segnò l’apice della sua notorietà. Nato agli inizi degli anni Venti negli ambiti del dibattito sullo scientific management, aveva in America, specialmente nella Taylor Society, i principali animatori. Rileggere le tesi esposte ad Amsterdam da queste correnti è interessante, molti argomenti vengono ripresi a distanza di anni, ma poco si riflette sulle cause che portarono al rapido fallimento del tentativo già in quegli anni. (In figura riportiamo alcuni testi che vennero pubblicati, già dai titoli è evidente come alcuni problemi siano una costante dopo ogni crisi).

Stabilizzare la società

I “Principles of scientific management” di Frederick Taylor (1911) si aprono con questa dichiarazione: «Il principale oggetto del management dovrebbe essere di assicurare il massimo di prosperità per il datore di lavoro, insieme al massimo di prosperità per ogni lavoratore». La diffusa opinione che interessi necessariamente antagonistici dividano il datore di lavoro dal suo dipendente sarebbe sbagliata: «Lo scientific management ha, al contrario, la ferma convinzione che i veri interessi dei due siano identici; che la prosperità per l’imprenditore non può durare molti anni se non è accompagnata dalla prosperità del lavoratore, e viceversa; e che è possibile dare al lavoratore ciò che maggiormente vuole – alti salari – e all’imprenditore ciò che vuole – un basso costo del lavoro – per le sue manifatture».

Le soluzioni che, partendo da questo punto di vista, potevano darsi alla profonda crisi di cui ancora si ignoravano le spaventose conseguenze furono esposte ad Amsterdam dal direttore della Taylor Society, Harlow S. Person.

Esisteva, sostenne, una terza via tra socialismo e capitalismo, il planning, che poteva poggiare su una nuova classe, «forse un centinaio di migliaia di tecnici, ingegneri e manager responsabili in ultima analisi della sussistenza e delle stesse vite di centoventi milioni di persone».

Le crisi, che periodicamente impediscono all’industria di esprimere le proprie potenzialità, erano ricondotte, dai tayloristi, alla contraddizione tra il principio fondamentale dell’impresa – intuizione e interesse individuale – e il principio fondamentale della tecnologia, l’integrazione cooperativa. Lo scientific management aveva affrontato questo problema applicando sistematicamente la ricerca, la standardizzazione, la pianificazione e il controllo, ma occorreva «trasferire questa tecnica dal piano delle singole imprese al piano della società». Lo scientific management, affermò Person, è naturalmente espansivo: nato per razionalizzare il singolo posto di lavoro, ha dovuto «stabilizzare» il reparto per riuscirvi, quindi la fabbrica per stabilizzare il reparto, e l’impresa per stabilizzare la fabbrica. «Ora comunque – concluse il direttore della Taylor Society – ci si rende conto che la completa stabilizzazione di una singola impresa di per sé non è possibile; che l’intera industria di cui fa parte deve essere stabilizzata. E probabilmente tutte le industrie di una nazione nei loro rapporti, e le relazioni industriali e commerciali sul piano internazionale».

Grandi sogni

Edward A. Filene, presidente degli omonimi grandi magazzini di Boston, celebrò ad Amsterdam l’apologia del fordismo. Il capitalismo era in grado di perseguire gli scopi di sempre, i profitti, con «mezzi diametralmente opposti»: «Il nuovo capitalismo realizza i profitti, tra le altre strategie, abbreviando la giornata di lavoro, mentre il vecchio capitalismo combatteva disperatamente ogni movimento per limitare le ore di lavoro. Il nuovo capitalismo sta realizzando profitti coltivando ed estendendo i principi di cooperazione. Esso esige, per la propria prosperità, che i suoi impiegati e il pubblico dei compratori siano prosperi. Esige addirittura la prosperità dei suoi concorrenti».

Lewis L. Lorwin, americano di origini russe, dirigente della Brookings Institution, sostenne la necessità di una pianificazione social progressista, non coercitiva, rispettosa della proprietà privata ma in grado, intervenendo parzialmente sul sistema di fissazione dei prezzi, di rimuovere la causa della crisi: l’irrazionalità di bassi salari e alti prezzi che impedivano di sfruttare le potenzialità della produzione di massa. Affermò: «La nostra comprensione e capacità di dirigere la vita economica sarà maggiore e migliore se il management e gli operai, e i lavoratori scientifici e tecnici sono riuniti allo scopo di fornire e la pianificazione e i poteri esecutivi per realizzare i piani. È questa un’immensa occasione per i gruppi tecnici e scientifici di realizzare un accordo sulla base di quello che è tecnicamente e obbiettivamente meglio per l’intera comunità». Giunse a proporre, in quella sede, l’istituzione di un consiglio di pianificazione mondiale, in grado di varare (addirittura!) un piano quinquennale mondiale.

Bruschi risvegli

La montagna partorì un topolino. Ambizioni così elevate confluiranno, in parte, nel New Deal americano (Lorwin entrerà nella National Recovery Administration), in parte nel calderone delle ideologie corporative del fascismo e del nazismo (il maggior esponente del socialismo europeo al congresso di Amsterdam, il belga Hendrik De Man, collaborerà con l’occupante tedesco), in parte forniranno argomenti alla tesi di chi, come Burnham, vedrà nel nazismo e nello stalinismo l’espressione politica della “nuova classe” dei manager.

Certamente, il massiccio intervento dello Stato nell’economia, nella Grande depressione prima e nella Seconda guerra mondiale poi, non corrispose, in nessun luogo, alle aspettative del planning scientifico.

Alfredo Salsano (“Ingegneri e politici”, Einaudi, 1987) riassume il «punto di vista dell’ingegnere», di cui il congresso dell’IRI fu a suo dire massima espressione, in tre convinzioni: in primo luogo i problemi economici sono problemi di gestione, cioè di mancanza di pianificazione; in secondo luogo i problemi sociali sono problemi di «relazioni umane», risolvibili con metodo scientifico; in terzo luogo la crisi è il prodotto di decisioni irrazionali che possono essere evitate senza ledere l’iniziativa (e la proprietà) privata. In altri termini, noi potremmo dire, manca la comprensione del lato caotico del capitalismo, che è scontro di interessi e non di idee.

Il presupposto dello scientific management è l’unicità del comando resa possibile dal fatto che, dentro la «singola fabbrica», non c’è anarchia perché non c’è mercato. L’«ingegnere», se si astrae dalla lotta dei salariati, non ha difficoltà a controllare i processi produttivi perché i prodotti, nell’ambito dell’impresa, sono semplici cose sottoposte a leggi di natura scientificamente conosciute e utilizzabili. Uscite sul mercato e trasformate in merci, quelle stesse cose divengono oggetto e strumento delle violente lotte che l’appropriazione privata di un prodotto sociale inevitabilmente genera. Per questo lo scientific management non è applicabile alla società e il sogno utopistico del world social economic planning finì nell’incubo reale della Seconda guerra mondiale.

La “stabilizzazione” della società capitalistica richiese sessanta milioni di morti, e il lungo sviluppo che ne è conseguito sta inesorabilmente accumulando nuovi giganteschi squilibri. È fuori discussione che le moderne forze produttive esigano una gestione scientifica, pianificata e coordinata a livello mondiale, ed è del tutto naturale che ingegneri e tecnici siano tra i più idonei a cogliere questa necessità. Ma l’ostacolo della proprietà privata dei mezzi di produzione sociali è inaggirabile; un tema che è vano cercare nei manuali degli ingegneri.

ENERGIA: LE PROSPETTIVE SECONDO UN MANAGER

Tra i tanti libri non specialistici (e a volte anche “partigiani”) che trattano il tema dell’energia segnaliamo “Con tutta l’energia possibile” di Leonardo Maugeri. Morto nel 2017, è stato a lungo dirigente dell’ENI assumendo, tra gli altri incarichi, quello di direttore Strategie e Sviluppo. Questa brevissima nota biografica serve certamente a inquadrare la posizione dalla quale l’autore parte per trattare il problema energetico nel suo complesso: quello del top manager di una grande azienda petrolifera, per cui il suo ruolo lo ha portato ad avere una visione specifica e generale del fenomeno.

Un’altra avvertenza è necessaria. Il testo è relativamente datato (pubblicato nel 2008) e quindi non prende in considerazione alcuni avvenimenti che nel frattempo sono accaduti come il disastro della centrale nucleare di Fukushima e la preannunciata rivoluzione dell’auto elettrica, mentre la rivoluzione dello shale gas e shale oil è già in qualche modo trattata.

Fatte queste premesse, il testo risulta molto interessante perché scandaglia tutte le fonti energetiche disponibili, inquadrandone la storia e la loro evoluzione tenendo conto delle variabili tecnologiche, economiche, e non ultime sociali.

Il libro parte dal presupposto secondo cui le fonti fossili (petrolio, carbone e gas) rappresentino di gran lunga l’energia primaria maggiormente in uso nel mondo (cosa valida anche oggi) affrontando il perché di questo dominio e valutando se altre fonti possano scalzarlo.

È interessante innanzi tutto una constatazione: l’introduzione delle fonti fossili ha storicamente rappresentato una evoluzione “ecologica” nello sfruttamento delle risorse precedenti. L’uso del carbone preservò almeno in parte la distruzione delle foreste e dei boschi che, all’inizio dell’era industriale, con il loro legno alimentavano fucine e officine. Allo stesso modo il petrolio e i suoi derivati, che sostituirono il carbone negli impianti di riscaldamento e nelle centrali termoelettriche delle città dell’occidente sviluppato, ne migliorarono drasticamente la qualità dell’aria, anche grazie al conseguente sviluppo delle tecnologie utili all’abbattimento delle sostanze inquinanti generate dalle combustione. Lo stesso vale con la sua ulteriore sostituzione col gas naturale.

Sicuramente il successo delle fonti fossili è dato dalla loro densità di energia e soprattutto dalla loro densità di potenza, che è uno dei concetti chiave del libro di Maugeri. Con la densità di potenza si misura il tasso di produzione di energia per unità di area terrestre considerata.

Un paio di esempi al riguardo aiutano a comprendere il concetto. Una centrale elettrica di media potenza (500 MW) alimentata a gas occupa un’area di circa 1 km2. Per ottenere la stessa potenza con un parco eolico, tenendo conto delle distanze minime da mantenere tra le turbine eoliche (circa 8 volte il diametro della turbina stessa) si dovrebbe occupare una superficie tra i 45 km2 per gli impianti offshore e il doppio (90 km2) per gli impianti a terra. Un altro esempio significativo è quello relativo ai biocarburanti: nonostante la gigantesca produzione di granturco statunitense che copre il 40% dell’intera produzione mondiale, se questa stessa produzione fosse tutta convertita in biofuel essa non riuscirebbe a coprire neanche il 10% del fabbisogno USA di combustibile per autotrazione.

I capitoli dedicati a petrolio e gas lasciano trasparire l’orgoglio del manager di una grande azienda di quel settore. Si vede bene quando smentisce l’idea diffusa che le grandi lobby petrolifere contrasterebbero lo sviluppo delle fonti alternative ricordando che, per esempio, sono state le grandi società petrolifere, americane soprattutto, a sviluppare la tecnologia del fotovoltaico per le sue applicazioni offshore e in luoghi remoti.

L’autore non tralascia di dedicare alcune pagine al problema della durata delle fonti fossili precisando che i concetti di riserve provate, riserve disponibili ecc. sono ad un tempo legati allo sviluppo tecnologico e alle condizioni del mercato. Prestigiosi istituti e importanti compagnie petrolifere che si sono avventurate nella previsione hanno sempre preso degli abbagli, come quando il Club di Roma lanciò l’allarme all’inizio degli anni ’80 sostenendo che il picco di produzione sarebbe stato a metà del decennio per avere poi un rapido e drammatico declino fino al dimezzamento alla soglia del 2000.

Nell’analisi che espone delle fonti alternative, Maugeri dà la sua preferenza al nucleare e al solare. Il nucleare gode del vantaggio della sua densità energetica superiore anche a quella delle fonti fossili e alla emissione sostanzialmente nulla di inquinanti. I maggiori problemi che sconta sono, oltre a quello delle scorie, quello dei costi reali e dei tempi di realizzazione di un impianto nucleare. Le valutazioni dei costi degli impianti realizzati fino ad ora non hanno tenuto conto delle spese di de-commissioning, ossia dello smontaggio e della bonifica dell’area a fine vita. Questi costi, che si evidenziano ora che molti impianti costruiti nei decenni scorsi sono arrivati a fine vita, stanno risultando quasi della stessa entità di quelli in costruzione.

Secondo l’autore quella solare è la fonte alternativa con le migliori prospettive per via di un mix di fattori. Innanzitutto il cruciale aspetto della densità di potenza che, sebbene più bassa delle fonti fossili, è superiore alle altre alternative. Ad esempio, impiegando una superficie pari a quella del comune di Roma (130.000 ettari) adibendola a campo fotovoltaico si potrebbe generare il 60% dell’intera energia elettrica consumata in Italia, ma utilizzandola a campo coltivato a colza per biodiesel si otterrebbe solo l’1% del diesel da autotrazione consumato nel paese.

Inoltre ci sono vari filoni di ricerca molto promettenti che puntano ad aumentare la resa energetica, come materiali diversi dal silicio o concentratori solari. Infine l’energia solare è maggiormente disponibile proprio quando serve di più, cioè di giorno.

Molto interessanti sono anche le valutazioni sugli aspetti sociali ed economici che potrebbero derivare da un maggiore sfruttamento delle risorse idriche per generare energia idroelettrica o del suolo per i biocarburanti.

Il libro quindi traccia alcune possibili dinamiche di una rivoluzione energetica che vede e vedrà sempre di più noi tecnici e ingegneri protagonisti. Il problema è che, pur da protagonisti tecnologici, c’è il rischio concreto che questa stessa rivoluzione venga vissuta in termini di minorità sociale, economica, e ideologica se non avremo consapevolezza del nostro ruolo. La coalizione di noi tecnici è l’unica strada affinché questi giganteschi mutamenti, portatori di svariati interessi e ideologie, vengano compresi in tutti i loro aspetti, e quindi non ci vedano come spettatori passivi, o gregari di interessi non nostri.

Fra le tante pubblicazioni su questo argomento oltre al libro in oggetto ci permettiamo di segnalare anche: “Energia e petrolio nella contesa imperialistica” di N. Capelluto e F. Palumberi.

L’AUMENTO MONDIALE DELLA SCOLARIZZAZIONE DEGLI OCCUPATI

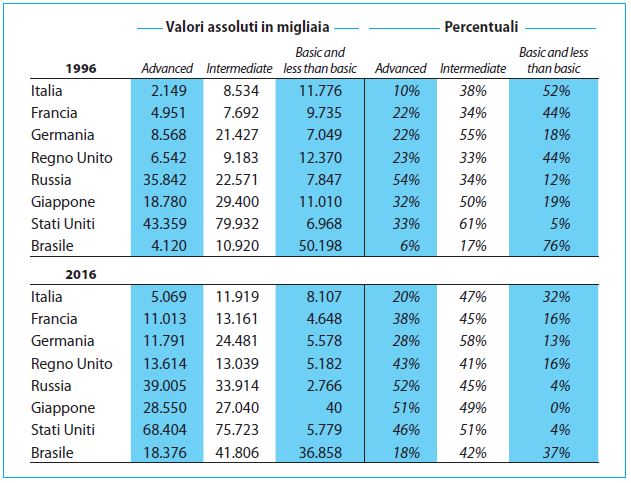

Le tabelle ILO (International Labour Office), per la quantità di informazioni che forniscono, sono una fonte utile e attendibile che abbiamo già utilizzato nel precedente numero del nostro bollettino. Continuiamo la pubblicazione con le nostre valutazioni.

In soli venti anni sono cambiati i valori assoluti e percentuali del grado di istruzione degli occupati. Nella tabella sono considerati solo i Paesi di più antica industrializzazione, perché sono quelli che forniscono i dati più attendibili e comunque sono i più interessanti visto che fanno da “apripista” per un trend che sarà poi seguito anche dalle nazioni di più recente industrializzazione La classificazione del livello scolastico è basata sullo standard ISCE-2011 (elaborata dall’Unesco) dove il livello “basic and less than basic” arriva fino alla soglia dell’istruzione secondaria inferiore (prendendo ad esempio l’Italia sarebbe la licenza di scuola media), il livello “intermediate” comprende fino alle scuole secondarie superiori ed il livello “advanced” intende lavoratori che posseggono almeno titoli di laurea breve, magistrale, dottorati, ecc.

Come si nota, la riduzione dei “basic and less than basic” è stata molto forte perché è richiesta una sempre maggiore istruzione che adegui gli occupati all’evoluzione rapida del sistema economico produttivo.

Nei paesi più sviluppati, in particolare in Europa, comincia a manifestarsi una difficoltà a reperire le competenze richieste. Secondo una indagine dell’Osservatorio delle competenze digitali 2018 (realizzata dalle maggiori associazioni dell’Ict come Aica, Anitec-Assinform, Assintel e Assinteritalia) in Italia c’è “un allarmante disallineamento tra domanda e offerta di competenze Ict” che “potrebbe diventare anche drammatica”. Nel 2017 servivano 20.500 laureati ma l’offerta del mercato è stata di sole 8.400 unità, quindi con un gap di irreperibilità pari al 59%. Da notare che la scarsità di profili con adeguate competenze e le relativamente basse retribuzioni, potrebbero essere l’occasione per rivendicare un minimo di adeguamento degli stipendi con i colleghi degli altri paesi europei, ma i sindacati non sembrano neppure accorgersi di questa possibile rivendicazione, e non tengono minimamente in considerazione questa dinamica e la congiuntura favorevole.

Per i paesi più sviluppati la sfida sarà formare i giovani in maniera adeguata, ma dato l’inverno demografico saranno comunque costretti ad attrarre sempre di più giovani qualificati da altri paesi; diversamente mancheranno ore di lavoro utili all’industria. È emblematico il caso ungherese: il governo, che è contro gli immigrati, per affrontare la carenza di forza lavoro ha alzato a 400 ore il limite legale di ore annue di straordinario.

Mentre per i Paesi in via di sviluppo la vera sfida sarà riuscire a trattenere una quota di questi lavoratori e garantire e incrementare, per le nuove generazioni, le strutture ed il personale adeguato; con una popolazione crescente tutto dovrà essere corrispondente: dagli edifici scolastici al numero di docenti.

È da registrare come si comportano due giganti economico-demografici che possono essere presi come paradigma della situazione mondiale: Giappone e India. Il primo è un ottimo rappresentante dei paesi pienamente sviluppati ma con una popolazione sempre più anziana, mentre il secondo è il simbolo dei paesi con una popolazione giovane e sempre più scolarizzata.

Il 16 luglio 2015 sul quotidiano “The Hindu” è apparsa la seguente affermazione del primo ministro indiano Narendra Modi: “Se la Cina è riconosciuta come la fabbrica manifatturiera del mondo, l’India può diventare la capitale delle risorse umane del mondo”. Nell’ottobre del 2017 è stato firmato un accordo tra India e Giappone, prevede che 100.000 giovani indiani vadano in Giappone, dove saranno impegnati in formazione tecnica pagata da Tokyo; di questi, a fine formazione, la metà potrà fermarsi a lavorare in loco.

È evidente che si tratta di un accordo che punta a portare vantaggi per entrambi i paesi: l’India che avrà al ritorno di una parte di questi studenti una forza-lavoro con livello di formazione avanzato e il Giappone che in cambio ne trattiene una parte per colmare i propri vuoti di forza-lavoro giovanile. È un accordo che mostra anche come “il mercato” della forza lavoro sia connesso a livello mondiale.

Guardando al passato, si può notare come, su scala inferiore, questi tipi di accordo siano già avvenuti: ad esempio, nel 2000 il governo tedesco (all’epoca il cancelliere era Gerhard Schroder) aveva autorizzato l’ingresso di alcune decine di migliaia di tecnici e ingegneri informatici, elettrici ed elettronici. Diversi Paesi prevedono dei visti speciali (il più famoso è l’H-1B statunitense) per attrarre manodopera qualificata, ovviamente i politici di turno, che spacciano paure, in questo caso omettono che siano anche “immigrati”; vedendo le previsioni ILO è probabile che forme di questo tipo verranno utilizzate sempre più spesso. Segnaliamo che in Germania il governo, prima delle festività natalizie, ha approvato una legge che dovrà essere ratificata dal parlamento nel 2019. L’obiettivo è sopperire alla grave carenza di personale specializzato che in alcuni settori e regioni rappresenta già ora un ostacolo alla crescita; le aziende hanno circa 1,2 milioni di posti di lavoro scoperti per mancanza di manodopera qualificata. Secondo il ministro del lavoro Hubertus Heil in sostanza “si tratta di non espellere le persone sbagliate”. Chi è qualificato e parla bene il tedesco potrà entrare in Germania anche se sprovvisto di un contratto e cercarsi un lavoro. Sono fatti e dinamiche da tenere ben presenti se non si vuole essere trascinati dai demagoghi di turno a subire passivamente, o peggio finire per parteggiare in battaglie non nostre.

Conoscere e studiare approfonditamente le dinamiche mondiali deve essere da stimolo per organizzarci in una coalizione sempre più ampia ed efficace.